| |

| |

|

|

Par le Professeur Jean Etourneau, Université de Bordeaux, membre du Conseil Scientifique de la Fondation

|

|

Il est patent que se met en place, depuis quelques années déjà, une intégration croissante des stratégies de recherche des laboratoires "académiques", couplées à une extension de leurs collaborations internationales, pour les rendre plus visibles et aborder les problèmes dans le cadre d'une plus forte transdisciplinarité. En France, le CNRS, en lien avec les Universités a ainsi créé des instruments tels que les Groupements de Recherche (GDR), les Laboratoires Internationaux Associés (LIA), les Laboratoires Mixtes, les Groupements d'Intérêt Scientifique (GIS) etc.

|

|

Plus récemment, de nouveaux outils ont été mis en place : Réseaux Thématiques de Recherche Avancés (RTRA), dès 2007, pour mobiliser des masses critiques de chercheurs de très haut niveau fédérés dans une stratégie commune, puis Laboratoires d'Excellence (LABEX), Equipements d'Excellence (EQUIPEX) et Initiatives d'Excellence (IDEX) financés par les Investissements d'Avenir.

Les laboratoires d'Aquitaine et de Midi-Pyrénées, du fait de l'excellence de leurs travaux et de leur dynamisme, bénéficient aujourd'hui de tous ces dispositifs, appuyés sur un "Plan Campus" lancé en 2008, pour rénover et dynamiser les sites universitaires. Tous les ingrédients sont donc réunis aujourd'hui pour renforcer les collaborations entre Aquitaine et Midi-Pyrénées. Pour faire face à une compétition internationale de plus en plus vive, l'intérêt des laboratoires de nos deux régions est de se rapprocher, dans un climat de confiance et d'échanges équilibrés, afin de montrer un front commun dans des projets ambitieux sur le long terme. De telles relations existent déjà, du fait notamment des actions du Pôle Aerospace Valley, dans de nombreux domaines. Quoi que déjà riches, ces collaborations restent encore ponctuelles et insuffisamment coordonnées autour d'objectifs compatibles avec les stratégies des deux régions.

L'un des domaines scientifiques privilégié pour développer de telles collaborations est celui de la Science des matériaux fonctionnels, structuraux et thermo-structuraux. Le parc d'équipements réunis à cet effet au sein des deux régions est déjà considérable. Plus de 2000 personnes y sont impliquées dans ce domaine, dont plus de la moitié sont des permanents travaillant majoritairement dans les laboratoires du CNRS et des Universités. Elles travaillent déjà ensemble, au sein du Pôle Aerospace Valley, dans le Domaine d'Activités Stratégiques (DAS) Aéronautique, Matériaux et Procédés (AMP).

Plus récemment, les actions du chantier VIMA du RTRA STAE, consacré au "vieillissement des matériaux" constituent une preuve de cet esprit collaboratif inter-régional. Une initiative conjointe a été prise récemment pour mettre en commun nos compétences complémentaires, sur ce thème. Plusieurs réunions ont déjà eu lieu et une conférence est programmée les 6-8 octobre 2014 à Sorèze. Par ailleurs, le développement de thèmes communs liés aux matériaux de substitution et au recyclage des matériaux, dont les enjeux sont considérables, offrent des opportunités sans précédent pour entreprendre ensemble des recherches fondamentales orientées vers les applications

La création d'Instituts de Recherche Technologique (IRT) qui ont pour mission de couvrir l'ensemble du processus d'innovation jusqu'au démonstrateur et au prototypage industriel devrait nourrir une réflexion sur le Transfert de Technologie, maillon très souvent manquant pour transformer les résultats de la recherche fondamentale en technologies et en produits. Nos deux régions vont ainsi collaborer de manière complémentaire dans le cadre de l'IRT "Aéronautique / Espace / Systèmes Embarqués", qui a été officiellement lancé en ce mois d'octobre 2013. La Plateforme "Composite à Matrice Céramique" de cet IRT, partagée entre partenaires académiques et PME, sera localisée à Bordeaux. Ce projet est en cours d'instruction par le CORAC et les services de l'Etat, pour une création en 2014.

L'esprit dans lequel travaillera cet IRT correspond à celui dans lequel seront lancés les appels d'offre européens "Horizon 2020" à la fin de l'année 2013, notamment dans le cadre des actions "Key Enabling Technologies" (KETs), pour lesquels une forte participation industrielle sera obligatoire.

|

|

|

|

Restitution du projet POGEQA (2009-2013)

|

|

Le séminaire de restitution du projet POGEQA (Plateforme d'Observation GEostationnaire de la Qualité de l'Air) s'est tenu le 26 juin 2013, sur le site de Météo-France à Toulouse.

|

- Contexte général du projet

La pollution chimique par des gaz tel que l'ozone (O3), les oxydes d'azote ou le monoxyde de carbone (CO), qui s'accumulent dans les basses couches atmosphériques du fait notamment des activités humaines, jouent un rôle central dans la préservation d'une bonne santé publique.

Les modèles numériques de prévision de la qualité de l'air (QA) s'appuient sur des mesures issues des réseaux locaux et de plus en plus sur des mesures spatiales. Les données spatiales proviennent actuellement de satellites défilants. Or, l'une des caractéristiques de la pollution atmosphérique près de la surface est sa variation diurne qui ne peut pas être déterminée par les satellites défilants, à cause de l'intervalle de temps entre deux passages sur un même point (jusqu'à plusieurs jours).

D'où l'idée d'explorer les possibilités d'un satellite géostationnaire pour accéder à la composition atmosphérique de la basse troposphère, qui conditionne la qualité de l'air.

|

|

|

|

Exemple de simulation de la colonne partielle 0-3km d'ozone simulée avec MOCAGE pour le 01/07/2009 à 12 UTC en utilisant les caractéristiques d'un instrument IR à bord d'un satellite géostationnaire.

|

|

|

- Aspects novateurs du projet

Le projet POGEQA a pour but d'étudier la valeur ajoutée provenant d'observations d'ozone et de monoxyde de carbone mesurées depuis une orbite géostationnaire pour la surveillance de la qualité de l'air en Europe. Le challenge de ce projet est de simuler les données obtenues par des capteurs géostationnaires en recherchant la configuration instrumentale optimale et d'évaluer leur apport dans les systèmes de prévision numérique.

- Collaborations mises en place dans le projet

Ce travail a été effectué par des chercheurs du CNRM et du Laboratoire d'Aérologie avec un support du Cerfacs, dont les compétences sont la simulation numérique de l'atmosphère et la mesure de chimie satellitaire.

Ont aussi collaboré au projet le LISA (Université de Créteil) (pour le transfert radiatif) et différents seniors étrangers (séjours de l'ordre du mois ou supérieur : W. Lahoz du NILU, Norvège ; J. Warner, Univ. Of Maryland).

Un industriel, Astrium, a été associé au projet et a contribué avec un soutien à deux bourses doctorales.

- Principaux résultats acquis

Le principal résultat de POGEQA est le développement d'un simulateur numérique de données satellitaires géostationnaires. Ce simulateur a permis d'une part de démontrer l'intérêt d'un satellite géostationnaire pour la prévision de la qualité de l'air et d'autre part de définir les caractéristiques d'un instrument à embarquer. Ceci a permis de faire une offre de mission (MAGEAQ) pour Earth Explorer 8 à l'ESA. Ce projet MAGEAQ a été bien évalué, mais finalement non retenu.

Les essais d'assimilation de données ont montré que l'utilisation de données issues d'un capteur géostationnaire permettrait de reproduire avec plus de précision la variabilité diurne de l'ozone et du monoxyde de carbone dans les couches les plus basses de l'atmosphère. Pour avoir la même couverture et les mêmes résultats il faudrait entre 6 et 12 satellites défilants.

|

|

Instrument infrarouge et visible dédié à la qualité de l'air, optimal pour la mesure de l'ozone et du monoxyde de carbone.

(concept réalisé par ASTRIUM pour un satellite géostationnaire)

|

|

- Retombées internationales

Un des plus grand succès de POGEQA c'est son impact international. Deux équipes internationales, une de la NASA et une autre de Corée du Sud ont décidé le lancement d'un géostationnaire pour la qualité de l'air. Ils ont profité des avancées développées dans le cadre de POGEQA pour les offres d'instrument qui ont été faites... L'équipe de POGEQA s'est intégrée à un consortium international ayant pour objectif de se doter d'une flotte de géostationnaires permettant de couvrir l'ensemble de régions de l'hémisphère Nord.

D'autre part, un consortium européen (Allemagne, Norvège, Hollande, Finlande) avec l'équipe POGEQA s'est mis en place et a obtenu une nouvelle proposition à l'ESA (ISOTROP) qui utilise le concept d'OSSE (Observing Simulated System Experiments) développé dans le cadre de POGEQA.

|

|

Restitution du projet MAELIA

|

|

"... et pourtant elle tourne..."

|

|

L'Atelier de restitution du projet MAELIA (Multi-Agents for EnvironmentaL norms Impact Assesment) s'est tenu le 10 Septembre devant un auditoire très diversifié d'une cinquantaine de personnes. La journée a débuté par une présentation des enjeux de la gestion de l'eau par l'Agence de l'eau du Bassin Adour-Garonne (BAG) et la Compagnie d'Aménagement des Coteaux de Gascogne (CACG). L'Agence de l'eau a pour objectif principal de maintenir sur ce "Grand Bassin" le bon état des masses d'eau et le bon fonctionnement des écosystèmes tout en favorisant un développement territorial durable pour lequel les ressources en eaux sont essentielles et irremplaçables. Malgré les "infrastructures de l'eau" (canaux, barrages, retenues collinaires, etc.) et les règlementations et dispositifs politiques et administratifs récents le déficit global du BAG - très dépendant du régime nival - se maintient aujourd'hui autour de 220 millions de m3 annuels. Il s'exprime tout particulièrement en période d'étiage, lorsque la demande en eau pour l'agriculture irriguée est la plus forte. L'hydroélectricité, très développée dans ce bassin, constitue une source importante d'énergie renouvelable mais génère des lâchers d'eau qui ne répondent pas aux enjeux du soutien d'étiage puisqu'essentiellement réalisés en hiver. De son côté la CACG a pour objet principal de concourir à l'aménagement, à l'équipement et au développement économique du BAG, pour le compte de collectivités et d'entreprises privées. Cela nécessite d'appréhender les échelles de temps et d'espace qui constituent des "clefs" pour les décisions des gestionnaires de l'eau : du lâcher de barrages, journalier, pour répondre aux besoins quotidiens, à la modélisation multi-décennale des effets hydrologiques du changement global et des pratiques agricoles ; de l'irrigation du bloc de parcelles aux infrastructures complexes à l'échelle de grands bassins versants.

|

|

Figure 1 : Synopsis de résultats d'une simulation réalisée avec la plateforme MAELIA sur la période 2002-2008 : assolement des cultures à l'échelle du bassin versant, rendements moyens des principales cultures irriguées (bleu = maïs) et pluviales (jaune au vert: le blé, le tournesol, le pois, le colza ...), quantité d'eau moyenne apportée par la pluie et irrigation dans les parcelles irriguées, débit d'eau à l'exutoire du bassin versant (les lignes jaune et rouge représentent le débit d'objectif d'étiage et le débit de crise).

|

|

|

|

Multiplicité des échelles, des acteurs, des ressources... comme toute problématique de gestion territoriale et environnementale, celle des étiages du BAG implique aussi une multiplicité de dimensions (juridique, écologique, hydrologique, sociologique, économique et... politique). La structure des modèles multi-agents est particulièrement bien adaptée pour rendre compte du comportement complexe d'un tel système "socio-écologique". Une telle "architecture numérique" est fondée sur la représentation explicite des acteurs (agriculteurs, EDF, Préfet, compagnie urbaine de l'eau...), des ressources matérielles (champs cultivés, bassin de retenue, cours d'eau...) ou cognitives (lois, décrets de restriction d'usages de l'eau, connaissances agricoles, données spatiales de l'état des sols ou des cultures...), et sur la modélisation de leurs interactions, via des processus écologiques et des activités humaines (pratiques agricoles, gestion des ressources stockées, etc.) selon des procédures explicites, sur une unité de gestion des ressources en eau donnée (en l'occurrence le bassin de la Garonne en amont de Toulouse). Ainsi s'est construit, sur 4 ans, le projet MAELIA. Durant ces 4 ans, ce projet a organisé et structuré le dialogue entre un grand nombre de spécialistes, issus de disciplines différentes, et dotés de compétences complémentaires. La plateforme de simulation des impacts des modes de gestion d'étiage ainsi construite est fondée sur quelques principes simples : la représentation multi-niveau et cohérente du territoire (sur une base physique et de gestion), une systématisation de l'appariement des bases de données hétérogènes disponibles (ressources, volumes prélevés, points de prélèvements et de rejets, occupation et usage des sols...) et la représentation de la rationalité des acteurs. Leurs décisions, stratégiques (ex. choix de rotation des cultures sur telle ou telle parcelle, décision de prélever dans telle retenue collinaire ou rivière) ou opérationnelles (ex. date de semis, des épisodes d'irrigation ou des lâchers de barrages) constituent la dimension sociale du moteur de simulation.

|

|

Figure 2 : Synopsis de l'impact des principaux processus simulés dans la plate-forme MAELIA sur le bassin de la Garonne amont, pour un jour donné : (1) niveau de précipitation par maille météorologique, (2) position spatiale des agriculteurs, (3) intensité d'irrigation dans les parcelles irriguées, (4) stade de croissance des cultures, (5) nature des cultures, (6) niveau de restriction de l'irrigation (arrêté préfectoral) par zone de restriction, (7) débit des rivières à l'exutoire de chaque sous bassin versant, (8) température de l'air.

|

|

Après quatre ans d'efforts, de concertation, d'interactions multiples entre les très nombreux artisans de la construction de la plateforme MAELIA (1), le résultat recherché est là... "... elle tourne...". Il ne s'agit cependant que d'un premier pas vers un modèle prédictif permettant l'évaluation quantitative de scenarios pour les décideurs. Le nouveau-né doit encore être soumis à des analyses d'incertitudes, à des calibrations variées, qui nécessiteront des centaines d'heures de calcul et un interfaçage avec de nombreux jeux de données réelles. Un opérateur "logiciel" - public ou privé - est aujourd'hui requis pour procéder à cette montée en "Technology Readiness Level" vers de futurs services opérationnels.

(1) 13 post-docs, 13 articles dans des revues à comité de lecture, 4 chapitres d'ouvrages, 11 Proceedings, 14 participations à des symposiums, 14 rapports de stages. D'autres articles sont en publication / soumission http://maelia1a.wordpress.com/

|

Pour en savoir plus Pour en savoir plus

|

|

Restitution du projet ADTAO et Conférence "Optimisation"

|

|

Du 24 au 26 juillet 2013 a eu lieu à Toulouse la conférence Recent Advances on Optimization, à l'occasion de la restitution du projet Assimilation de Données pour la Terre, l'Atmosphère et l'Océan (ADTAO) soutenu par la Fondation RTRA-STAE.

|

|

Image Météo-France obtenue par superposition d'un champ de pression de surface à une image Météosat illustrant un front de perturbation.

|

|

|

Le projet ADTAO a été le résultat d'un partenariat entre laboratoires toulousains se spécialisant en calcul scientifique (IRIT, CERFACS) et en assimilation de données opérationnelles (Météo-France, CNES, CERFACS). Ce projet a rendu possible la venue de nombreux experts scientifiques à Toulouse, notamment Iain Duff (Rutherford Appleton Laboratory), Jan Mandel (University of Colorado Denver), Andrew Moore (University of California Santa Cruz), Philippe Toint (Université de Namur) et Luis Vicente (Universidade de Coimbra). Les collaborations ainsi entamées ont donné lieu à de nombreuses avancées scientifiques, publiées dans des journaux internationaux, par exemple dans les domaines de l'optimisation numérique, des méthodes itératives, des techniques de préconditionnement et de la modélisation de covariances ; l'originalité du projet est que ces idées novatrices ont pu être mises en oeuvre dans des logiciels d'assimilation de données opérationnels tels que ARPEGE-IFS, GINS, NEMOVAR ou ROMS. Les différents acteurs du projet, dont Serge Gratton (IRIT-CERFACS), Anthony Weaver (CERFACS), Loïk Berre (Météo-France) et Philippe Toint ont d'ailleurs profité d'une session de la conférence dédiée au projet ADTAO pour présenter les résultats saillants du projet.

La conférence a aussi permis aux 110 participants (issus du monde de la recherche académique comme de celui de l'industrie, d'une quinzaine de nationalités différentes) d'assister à des exposés dans plusieurs domaines de l'optimisation. En plus des résultats présentés par les membres du projet ADTAO, Mike Fisher (ECMWF) et Olivier Talagrand (Ecole Normale Supérieure de Paris) ont également décrit les liens existant entre la modélisation climatique, l'optimisation et l'assimilation de données. L'optimisation sans dérivées, domaine très actif, était également présente : Katya Scheinberg (Lehigh University) et Luis Vicente ont insisté sur les aspects modernes de l'analyse théorique de ces méthodes ; Yves Lucet (The University of British Columbia) a présenté un nouvel algorithme de point proximal, tandis que John Dennis (Rice University) centrait son exposé sur les différentes applications industrielles de ces méthodes ainsi que sur les évolutions futures du domaine. Les algorithmes de régions de confiance ont fait l'objet de plusieurs exposés. Ya-Xiang Yuan (Chinese Academy of Sciences) a détaillé un algorithme de Lagrangien augmenté entrant dans cette catégorie, tandis que Mike Saunders (Stanford University) a comparé plusieurs méthodes de résolution des sous-problèmes associés à l'algorithme des régions de confiance. La présentation de Michael Powell (Cambridge University) était consacrée à un logiciel servant à générer rapidement des pas pour de tels algorithmes. Les méthodes d'optimisation prenant en considération une modélisation aléatoire ont été également mises à l'honneur avec les exposés de Jorge Moré (Argonne National Laboratory) sur le traitement du bruit numérique, Stephen Wright (University of Wisconsin-Madison) qui a expliqué les méthodes de parallélisation des algorithmes aléatoires, ou encore Jorge Nocedal (Northwestern University) qui visait à estimer la courbure d'une fonction à l'aide de gradients stochastiques.

|

|

D'autres domaines de l'optimisation ont également été abordés au cours de la conférence. Stefania Bellavia (University of Florence) a ainsi présenté des travaux sur les régularisations de systèmes non linéaires ; Donald Goldfarb (Columbia University) a exposé des travaux sur la récupération de données utilisant les tenseurs.

|

|

|

Benedetta Morini (University of Florence) et Annick Sartenaer (Université de Namur) ont abordé des problèmes de préconditionnement, respectivement pour des résolutions de suites de systèmes linéaires et de problèmes de points selles. Michael Kocvara (Birmingham University) a introduit une nouvelle bibliothèque MATLAB dédiée à la résolution par méthodes de pénalisation. Andreas Griewank (Humboldt University) a quant à lui présenté plusieurs éléments d'optimisation non lisse, en lien avec la linéarité par morceaux.

|

Durant les trois jours, des posters étaient exposés dans le hall du centre de conférences, illustrant diverses applications des méthodes d'optimisation. Le deuxième jour, les participants ont été conviés à l'hôtel d'Assézat de Toulouse pour une visite du musée suivie d'un cocktail dinatoire. La conférence a également été l'occasion de célébrer les multiples collaborations de Philippe Toint dans tous les domaines de l'optimisation précités.

L'ensemble des contributions des orateurs sont disponibles à l'URL

http://www.cerfacs.fr/6-27084-Recent-Advances-on-Optimization.php

|

|

|

|

Le chantier MoMa et les projets ADTAO et FILAOS

|

|

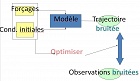

L'assimilation de données regroupe un ensemble de techniques mathématiques et algorithmiques permettant de réaliser des prévisions dans des systèmes non linéaires, modélisés de façon stochastique, qui sont observés par des senseurs terrestres ou spatiaux.

|

|

La météorologie, et plus généralement les géosciences, font partie de leurs champs d'application et nécessitent le recours à des outils de simulation sophistiqués sur des calculateurs parallèles.

Le chantier MoMA (MéthOde mathématiques pour le couplage modèle/données dans les très grands systèmes) a pour objectif de réaliser et de faire progresser les algorithmes de cette discipline, de les mettre à l'épreuve dans des cas d'études de la vie réelle, puis de les intégrer, si leurs performances et leur fiabilité le justifient, dans des systèmes opérationnels. Les travaux sont réalisés dans le cadre de partenariats étroits entre experts des algorithmes situés au CERFACS, au CNES, à l'IRIT, à Météo-France ou à l'OMP.

Les questions principalement étudiées dans le chantier concernent deux problématiques essentielles en assimilation de données. La première vise à trouver des algorithmes d'optimisation permettant de réaliser l'ajustement de paramètres des modèles qui vont être utilisés pour réaliser des prédictions. La seconde étudie la modélisation des erreurs des modèles, et des mesures issues des senseurs. Le chantier MoMA s'articule actuellement autour des deux projets ADTAO et FILAOS, qui correspondent chacun à des approches différentes pour aborder le problème.

Le projet ADTAO s'intéresse à une modélisation variationnelle issue du maximum de vraisemblance dans un cadre Gaussien, dans laquelle il s'agit in fine de résoudre un problème aux moindres carrés non linéaires ayant plusieurs millions de degrés de liberté. Un tel problème, lorsqu'il est fortement non-linéaire et met en jeu un grand nombre de paramètres reste un challenge important en optimisation numérique. Des progrès importants ont pu être réalisés dans le cadre d'ADTAO, comme l'a montré la journée de restitution du projet qui a été adossée à la conférence internationale sur l'optimisation de Juillet 2013 présentée ci-dessous. Le projet FILAOS (FILtrage stochastique pour problèmes non linéaires de grande taille et applications à l'Assimilation des ObservationS en grandeur réelle) s'intéresse à une technique d'estimation issue du filtrage de Kalman, qui présente la particularité de donner lieu à des algorithmes pour lesquels il n'est pas nécessaire d'avoir accès aux modèles linéaires et adjoints du modèle, qui sont souvent couteux à évaluer.

Ces approches interviennent à un moment charnière de la recherche où les différents acteurs des applications s'interrogent sur la technique à choisir, lorsqu'il s'agit de réaliser les meilleures prédictions, avec une utilisation optimale des calculateurs parallèles disponibles. Il est difficile de savoir au moment de la rédaction de cet article laquelle des deux approches s'imposera, ou si, comme souvent, l'optimalité ne résultera pas d'une hybridation ingénieuse de ces approches, dont l'efficacité reste à prouver dans des systèmes de la vie réelle.

|

|

Symposium "Unsteady Separation in Fluid-Structure Interaction"

|

|

Ce symposium international, présidé par Marianna Braza (IMFT, France), Alessandro Bottaro (Univ. Genova, Italie) et Mark Thompson (Univ. Monash, Australie), s'est tenu du 17 au 21 juin 2013, à Mykonos (Grèce).

Il fait partie des activités d'animation scientifique du chantier "SMARTWING", coordonné par l'Institut de Mécanique des Fluides de Toulouse et a reçu également le label de l'organisme européen ERCOFTAC, "European Research Community on Flow, Turbulence and Combustion".

|

|

Le symposium était organisé autour de neuf sessions plénières couvrant les thèmes scientifiques fédératifs de la problématique "interactions fluide-structures" associées aux écoulements décollés instationnaires. Il était composé d'une soixantaine de présentations orales, et de quatorze conférences plénières regroupant des scientifiques de renommée mondiale ainsi que des coordonnateurs de programmes de recherche européens du FP7. On a pu dénombrer un total de 80 participants.

L'un des objectifs du symposium était le rapprochement des communautés scientifiques de la Mécanique des Fluides et des Structures, afin de proposer des concepts novateurs pour le design en aérodynamique et hydrodynamique. Les thèmes des sessions couvrent les aspects théoriques, expérimentaux et numériques de cette thématique.

Liste des sessions :

- Aspects théoriques de l'interaction fluide-structure (IFS) avec décollement

- Instabilité et transition associées aux décollements

- Matériaux intelligents et morphing électroactif

- Biomimétique pour conception intelligente de structures, "smart-wing design"

- Techniques expérimentales pour la dynamique des décollements sous vibrations induites par vortex, mouvement et turbulence, VIV, MIV, TIV

- Effets de compressibilité en IFS associée à des écoulements décollés

- Simulation Numérique Directe (DNS) d'écoulements décollés instationnaires

- Modélisation de la turbulence en IFS : approches statistiques (URANS), LES et hybrides (URANS-LES)

- Stratégies de couplage fluide-structure

- Contrôle du décollement instationnaire associant des matériaux intelligents

|

|

Les discussions menées lors du symposium ont permis de dresser un panorama des méthodes les plus efficaces pour le calcul des charges instationnaires subies par les structures solides, mobiles ou déformables, sous l'effet du décollement d'un écoulement fluide. Ceci constitue l'un des verrous importants pour le design de nouveaux dispositifs.

|

|

|

Des concepts innovants ont été proposés pour conduire à l'atténuation du bruit et au contrôle d'instabilités nuisibles. Ces nouvelles approches se basent sur la modification de la structure solide par le moyen d'actuations intelligentes (morphing). Certaines de ces méthodes ont été fortement inspirées par la biomimétique.

L'ensemble de ces idées est développé dans les actes du symposium. De plus, une trentaine d'articles a été sélectionnée pour publication, sous forme plus étendue, dans un volume dédié à cette thématique, au sein du Journal of Fluids and Structures.

|

Pour en savoir plus Pour en savoir plus

|

|

|

|

NanoQuébec : un réseau en nanotechnologies au Québec

|

|

Par Mohamed Chaker, Président du Comité des Affaires Scientifiques de NanoQuébec

|

|

|

Créé en 2001 par le gouvernement du Québec, NanoQuébec a pour objectif de favoriser l'essor des nanotechnologies au Québec. À travers ses différents programmes, NanoQuébec assure un développement optimum des nanotechnologies depuis la recherche académique jusqu'aux applications industrielles et la sensibilisation du grand public.

|

- Une infrastructure de classe mondiale

NanoQuébec assure le soutien et le développement de l'Infrastructure québécoise en nanotechnologie (IQN), qui regroupe plus de 300 M$ d'équipements de pointe en micronanofabrication, caractérisation et synthèse de nanomatériaux et 300 personnes hautement qualifiées nécessaires au développement de nouvelles connaissances ou applications dans le domaine des nanotechnologies.

|

|

|

- L'innovation ouverte au coeur du développement des applications

Lancée par NanoQuébec, iNano est la première plateforme d'innovation ouverte au Canada. Elle permet à des industriels de soumettre des défis technologiques à une vaste communauté de recherche, qui peut ensuite proposer des pistes de solutions. 145 défis ont déjà été soumis par les industriels, qui ont reçu près de 350 solutions. 45 projets ont pu être démarrés grâce au maillage défi-solution, positionnant les nanotechnologies comme source d'innovation de premier plan.

|

En savoir plus sur iNano En savoir plus sur iNano

|

- De la recherche aux consommateurs

NanoQuébec dispose de différents outils de financement qui permettent de couvrir l'ensemble de la chaîne d'innovation, de la recherche universitaire ou de la recherche-développement jusqu'à la recherche appliquée. De plus, une attention particulière est portée aux aspects relatifs à la santé et à la sécurité des nanotechnologies, domaine dans lequel l'organisme contribue, par du financement, à faire avancer les connaissances et à diffuser les pratiques d'excellence. NanoQuébec croit fermement que le développement responsable des nanotechnologies doit tenir compte de la santé et de la sécurité au travail ainsi que des enjeux environnementaux et de l'acceptation sociale.

|

En savoir plus sur NanoQuébec En savoir plus sur NanoQuébec

|

Contacts :

- Benoit Balmana, Président-directeur général de NanoQuébec. benoit.balmana@nanoquebec.ca

- Mohamed Chaker, Président du Comité des Affaires Scientifiques de NanoQuébec

chaker@emt.inrs.ca

|

|

|

|

Global off-line evaluation of the ISBA-TRIP flood model.

Auteurs : Decharme B., R. Alkama, H. Douville, C. Prigent, F. Papa, S. Faroux

2012

Parution : Climate Dyn., 38, 1389-1412, doi:10.1007/s00382-011-1054-9

Nom du projet : CYMENT

Anthropogenic influence on multi-decadal changes in reconstructed global evapotranspiration.

Auteurs : Douville H., B. Decharme, A. Ribes, R. Alkama, J. Sheffield

2012

Parution : Nature Climate Change, doi:10.1038/NCLIMATE1632

Nom du projet : CYMENT

|

|

Toutes les publications Toutes les publications

|

|

|

|

|